인공신경망(ANN)과 다층 퍼셉트론(MLP)

이전 포스트에서 단층 퍼셉트론이 행렬 연산을 통해 다음 노드로 정보를 전달하는 과정을 살펴보았다. 이전에 학습했었던 퍼셉트론과의 차이점은 활성화 함수로 계단 함수가 아닌 시그노이드 함수를 사용한 것이다.

이렇게 활성화 함수에 정보를 전달하느냐 마느냐인 계단 함수를 넣는 것이 아니라, 시그노이드, 소프트맥스, 하이퍼볼릭 탄젠트, 렐루 등 다양한 활성화 함수를 넣고, 단층 퍼셉트론이 아닌, 다층 퍼셉트론을 만들고, 가중치를 인간이 수동으로 만드는 것이 아닌, 자동으로 가장 적합한 값을 찾아내는 것이 바로 인공 신경망이다.

1. 신경망의 구조

- "입력층 - 출력층"만 존재하는 단층 퍼셉트론(Single Layer Perceptron, SLP)과 달리 "입력층 - m개의 은닉층 - 출력층"이 존재하는 다층 퍼셉트론(Multi Layer Perceptron)은 "n-층 신경망"이라고도 부르며, 일반적으로 단층 퍼셉트론처럼 입력층을 제외하고 부르거나, 입력층을 0층으로 생각하고 "n = m + 1"로 은닉층의 개수 + 출력층 1개로 명명한다.

- 즉, 아래 다층 퍼셉트론은 3-층 신경망이라고 부른다.

- 이렇게 은닉층이 2개 이상인 신경망을 심층 신경망(Deep Neural Network)라 한다.

- 그러나, 간혹 다른 책에선 입력층까지 포함하여 m+2 층 신경망, 아래 예시에선 4-층 신경망이라 부르는 경우도 있다. 본, 블로그에서는 "은닉층의 수(m) + 출력층 1개"인 m+1층 신경망이라 부르도록 하겠다.

-

입력층(Input Layer):

파란색 노드로, 학습 데이터셋(Train dataset)이 입력되는 곳이다. 학습 데이터의 Feature의 차원 수만큼의 뉴런 개수를 가진다. 입력층은 단 한층만 존재한다. -

은닉층(Hidden Layer):

연두색 노드로, 입력층과 출력층 사이의 모든 층이다. 은닉층이라 불리는 이유는 입력층과 출력층은 Input 되는 Dataset과 Output 된 Dataset을 눈으로 확인할 수 있지만, 은닉층은 보이지 않기 때문이다. -

출력층(Output Layer):

주황색 노드로, 출력하고자 하는 데이터의 형태에 따라 노드의 수가 바뀐다. 예를 들어, 0부터 9까지 10 종류의 숫자가 있다고 할 때, 이를 분류하고자 한다면, 출력층의 노드 수는 10개가 되며, 시그모이드 함수를 사용하여, 이진 분류를 하고자 하는 경우엔 노드의 수가 1개가 된다.

2. 다층 퍼셉트론의 연산

- 다층 퍼셉트론의 연산 방식은 앞서 다뤘던 단층 퍼셉트론의 연산 방식과 동일하나, 더 많이 실시하게 된다.

- 가중치를 알아서 찾아내는 방식은 뒤에서 다루도록 하고, 이번에는 가중치를 임의로 만들어보자.

$$ X = (x_1, x_2, x_3) = (10, 2) $$

$$ W_1=

\begin{pmatrix}

w_{11}^{(1)} & w_{21}^{(1)} & w_{31}^{(1)}\\

w_{12}^{(1)} & w_{22}^{(1)} & w_{32}^{(1)}

\end{pmatrix}

=

\begin{pmatrix}

0.1 & 0.3 & 0.5\\

0.6 & 0.4 & 0.2

\end{pmatrix} $$

$$W_2=

\begin{pmatrix}

w_{11}^{(2)} & w_{21}^{(2)}\\

w_{12}^{(2)} & w_{22}^{(2)}\\

w_{13}^{(2)} & w_{23}^{(2)}

\end{pmatrix}

=

\begin{pmatrix}

0.1 & 0.2\\

0.2 & 0.4\\

0.3 & 0.6

\end{pmatrix}$$

$$W_3=

\begin{pmatrix}

w_{11}^{(3)} & w_{21}^{(3)}\\

w_{12}^{(3)} & w_{22}^{(3)}\\

\end{pmatrix}

=

\begin{pmatrix}

0.2 & 0.4\\

0.4 & 0.8

\end{pmatrix}$$

$$B_1 = (b_{1}^{(1)}, b_{2}^{(1)}, b_{3}^{(1)})=(0.7, 0.6, 0.5)$$

$$B_2 = (b_{1}^{(2)}, b_{2}^{(2)})=(0.6, 0.4)$$

$$B_3 = (b_{1}^{(3)}, b_{2}^{(3)})=(0.5, 0.6)$$

- 활성화 함수는 은닉층에서는 렐루 함수를 사용하고, 출력층에서는 시그모이드 함수를 사용해보자.

- 즉, $f()$는 렐루 함수, $h()$는 시그모이드 함수이다.

3. 구현해보자.

- 먼저 데이터를 생성하고, 데이터의 모양을 봐야 한다.

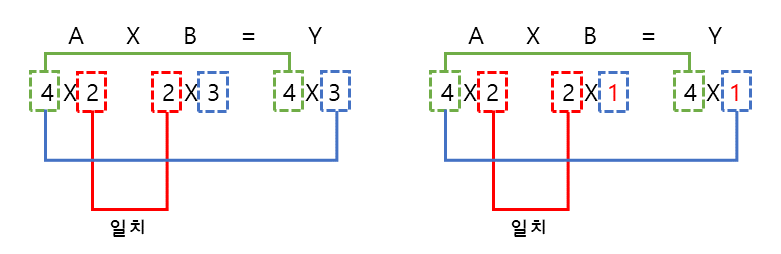

- 기계학습에선 행렬곱이 주를 이르므로, 행렬의 모양을 파악하는 것이 최우선이다.

>>> X = np.array([10, 2])

>>> W1 = np.array([[0.1, 0.3, 0.5], [0.6, 0.4, 0.2]])

>>> W2 = np.array([[0.1, 0.2],[0.2, 0.4],[0.3, 0.6]])

>>> W3 = np.array([[0.2, 0.4],[0.4, 0.8]])

>>> B1 = np.array([0.7, 0.6, 0.5])

>>> B2 = np.array([0.6, 0.4])

>>> B3 = np.array([0.5, 0.6])

>>> print("X Shape:", X.shape)

>>> print("----"*20)

>>> print("W1 Shape:", W1.shape)

>>> print("W2 Shape:", W2.shape)

>>> print("W3 Shape:", W3.shape)

>>> print("----"*20)

>>> print("B1 Shape:", B1.shape)

>>> print("B2 Shape:", B2.shape)

>>> print("B3 Shape:", B3.shape)

X Shape: (2,)

--------------------------------------------------------------------------------

W1 Shape: (2, 3)

W2 Shape: (3, 2)

W3 Shape: (2, 2)

--------------------------------------------------------------------------------

B1 Shape: (3,)

B2 Shape: (2,)

B3 Shape: (2,)

- 중요한 것은 노드와 가중치 엣지의 모양이다.

- 편향은 위 노드와 가중치 엣지의 모양만 제대로 맞게 이루어져 있다면, 벡터 합이 당연히 되므로, 신경 쓰지 않아도 된다.

>>> def ReLU(x):

>>> return np.maximum(0, x)

>>> def sigmoid(x):

>>> return 1 / (1 + np.exp(-x))

# 입력층에서 출력층 방향으로 계산된다.

>>> A1 = np.dot(X, W1) + B1

>>> Z1 = ReLU(A1)

>>> A2 = np.dot(Z1, W2) + B2

>>> Z2 = ReLU(A2)

>>> A3 = np.dot(Z2, W3) + B3

>>> Y = sigmoid(A2)

>>> Y

array([0.97180471, 0.9981301 ])- 위 코드를 보면, 입력층 X에서 출발한 데이터가 "행렬곱 > 활성화 함수 > 행렬곱 > 활성화 함수 > 행렬곱 > 활성화 함수 > 출력"의 형태로 진행된 것을 알 수 있다.

- 이를 보면, 단층 퍼셉트론을 활성화 함수만 바꾸면서 층을 쌓듯 여러 번 수행된 것을 알 수 있다.

4. 순전파(Forward Propagation)

- 위 신경망에서 데이터의 흐름은 입력층에서 출력층의 방향으로 전달되었는데, 이를 순전파라고 한다.

- 위에서 인공 신경망은 스스로 가장 적합한 가중치를 찾아간다고 하였는데, 이를 우리는 학습이라고 하며, 이 학습은 역전파(Back Propagation) 과정을 통해 이루어진다.

- 만약 내가 신경망의 틀을 만들고, 그 신경망에서 가장 적합한 가중치를 찾는 것을, 이는 학습을 한다고 하며, 모델을 만든다라고 한다. 지금 같이 이미 가중치를 알고 있는 상태는 학습이 끝난, 모델이 완성된 상태이며, 이 모델에 데이터를 집어넣어, 그 결과를 확인하는 것은 순전파 되어 실행된다.

지금까지 이미 가중치가 얻어진 다층 퍼셉트론(MLP)을 이용해, 신경망이 어떻게 연산되는지를 알아보았다. 신경망의 연산은 행렬곱과 활성화 함수 이 두 가지를 통해서 구해지는, 생각보다 단순한 알고리즘인 것을 알 수 있다.

다음 포스트에서는 그렇다면 대체 그 학습이라는 과정은 어떻게 이루어지는 지에 대해 알아보도록 하겠다.

'Machine Learning > Deep Learning' 카테고리의 다른 글

| 딥러닝-5.0. 손실함수(1)-제곱오차(SE)와 오차제곱합(SSE) (0) | 2021.01.29 |

|---|---|

| 딥러닝-4.2. 인공신경망(3)-신경망 학습 (0) | 2021.01.28 |

| 딥러닝-4.0. 인공신경망(1)-신경망 연산(SLP) (0) | 2021.01.28 |

| 딥러닝-3.5. 활성화함수(6)-ReLU Family (0) | 2021.01.27 |

| 딥러닝-3.4. 활성화함수(5)-렐루 함수(ReLU) (0) | 2021.01.27 |