연립일차방정식과 가우스 소거법

- 앞서 행렬은 연립일차방정식의 계수와 변수를 분리하여 사용하게 되면서 등장하였다고 했다.

- 앞서 행렬의 기본적인 성질은 배웠으니, 이제 연립일차방정식과 행렬이 어떻게 연결되는지에 대해 알아보자.

- 연립일차방정식을 통해 첨가 행렬을 만들어보고, 가우스 소거법으로 연립일차방정식을 풀이해보자.

1. 연립일차방정식(System of Linear equations)

1.1. 일차방정식(Linear equation)

- 미지수 $x_1, x_2, x_3, ..., x_n$에 관한 일차방정식은 상수 $b$와 계수 $a_1, a_2, a_3, ..., a_n$이 실수일 때, 다음과 같은 꼴로 나타나는 방정식이다.

- 일차방정식이므로, 미지수 $x_1, x_2, x_3, ..., x_n$의 차수는 1이다.

$$a_1x_1 + a_2x_2 + a_3x_3 + \cdots a_nx_n = b$$

1.2. 연립일차방정식(System of Linear equations)

- 미지수 $x_1, x_2, x_3, ..., x_n$에 대하여 유한개의 일차방정식 모임은 아래와 같다.

$$a_{11}x_1 + a_{12}x_2 + a_{13}x_3 + \cdots a_{1n}x_n = b_1$$

$$a_{21}x_1 + a_{22}x_2 + a_{23}x_3 + \cdots a_{2n}x_n = b_2$$

$$a_{31}x_1 + a_{32}x_2 + a_{33}x_3 + \cdots a_{3n}x_n = b_3$$

$$ \vdots $$

$$a_{m1}x_1 + a_{m2}x_2 + a_{m3}x_3 + \cdots a_{mn}x_n = b_m$$

- 실수 $b_1, b_2, b_3, ..., b_m$이 모두 0이면 이 연립방정식을 동차(Homogeneous)라 하며, 반대의 경우에는 비동차(non-Homogeneous)라 한다.

- 미지수 $x_1, x_2, x_3, ..., x_n$에 대하여 어떤 수 $s_1, s_2, s_3, ..., s_n$을 각각 대입하여, 각 방정식이 모두 성립하면 어떤 수 $s_1, s_2, s_3, ..., s_n$을 연립일차방정식의 해(Solution)이라 한다.

- 연립일차방정식의 해 전체 집합을 연립일차방정식의 해집합(Solution set)이라 한다.

- 동일한 해집합을 가지는 두 연립일차방정식을 동치(Equivalent)라고 한다.

- 연립일차방정식의 해에 대하여, 일반적으로 다음 중 하나가 성립한다.

- 해를 갖지 않는다.

- 유일한 해를 갖는다.

- 무수히 많은 해를 갖는다.

1.3. 연립일차방정식과 행렬

- 위 연립일차방정식을 행렬로 나타내면 다음과 같다.

$$A = \begin{pmatrix}

A_{11}& A_{12} & A_{13} & ... & A_{1n}\\

A_{21}& A_{22} & A_{23} & ... & A_{2n}\\

A_{31}& A_{32} & A_{33} & ... & A_{3n}\\

\vdots & \vdots & \vdots & \ddots & \vdots\\

A_{m1}& A_{m2} & A_{m3} & ... & A_{mn}\\

\end{pmatrix},\ \ \

X = \begin{pmatrix}

x_1\\

x_2\\

x_3\\

\vdots \\

x_n

\end{pmatrix},\ \ \

B = \begin{pmatrix}

b_1\\

b_2\\

b_3\\

\vdots \\

b_m

\end{pmatrix}$$

$$AX = B$$

- 우리가 지금까지 봐왔던, 행렬은 바로 $A$로 이를 계수행렬(Coefficient matrix)라 한다.

2. 첨가행렬(Augmented matrix)

- 계수행렬 $A$와 상수항들이 모여서 만들어진 행렬$B$를 붙이면 첨가행렬(Augmented matrix)가 만들어진다.

$$(A | B) = \begin{pmatrix}

A_{11}& A_{12} & A_{13} & ... & A_{1n} | b_1\\

A_{21}& A_{22} & A_{23} & ... & A_{2n} | b_2\\

A_{31}& A_{32} & A_{33} & ... & A_{3n} | b_3\\

\vdots & \vdots & \vdots & \ddots & \ \ \ \vdots \ \ | \ \vdots \\

A_{m1}& A_{m2} & A_{m3} & ... & A_{mn} | b_m\\

\end{pmatrix}$$

- 첨가행렬은 행렬 방정식의 풀이와 역행렬 구하기에 응용된다.

- 가우스 소거법을 사용하여 연립일차방정식을 풀이해보자.

3. 가우스 소거법(Gaussian elimination)

- 선형대수학에서, 가우스 소거법은 연립일차방정식을 풀이하는 알고리즘으로, 풀이 과정에서 일부 미지수가 차츰 소거되어, 남은 미지수에 대한 선형 결합으로 풀이가 완성된다.

- 가우스 소거법은 보통 행렬을 사용하며, 첨가 행렬을 그와 풀이가 더 간단한 행렬로 변환하여 풀이를 완성한다.

- 가우스 소거법은 행렬식과 역행렬의 계산에도 응용된다.

- 가우스 소거법은 맨 위 일차방정식부터 임의의 k를 곱해가며 아래에 있는 일차방정식들을 하나하나 맨 앞의 계수부터 0으로 만들어가는 방법으로, 최종적으로 주대각선의 모든 값이 1인 상삼각행렬을 만들게 된다.

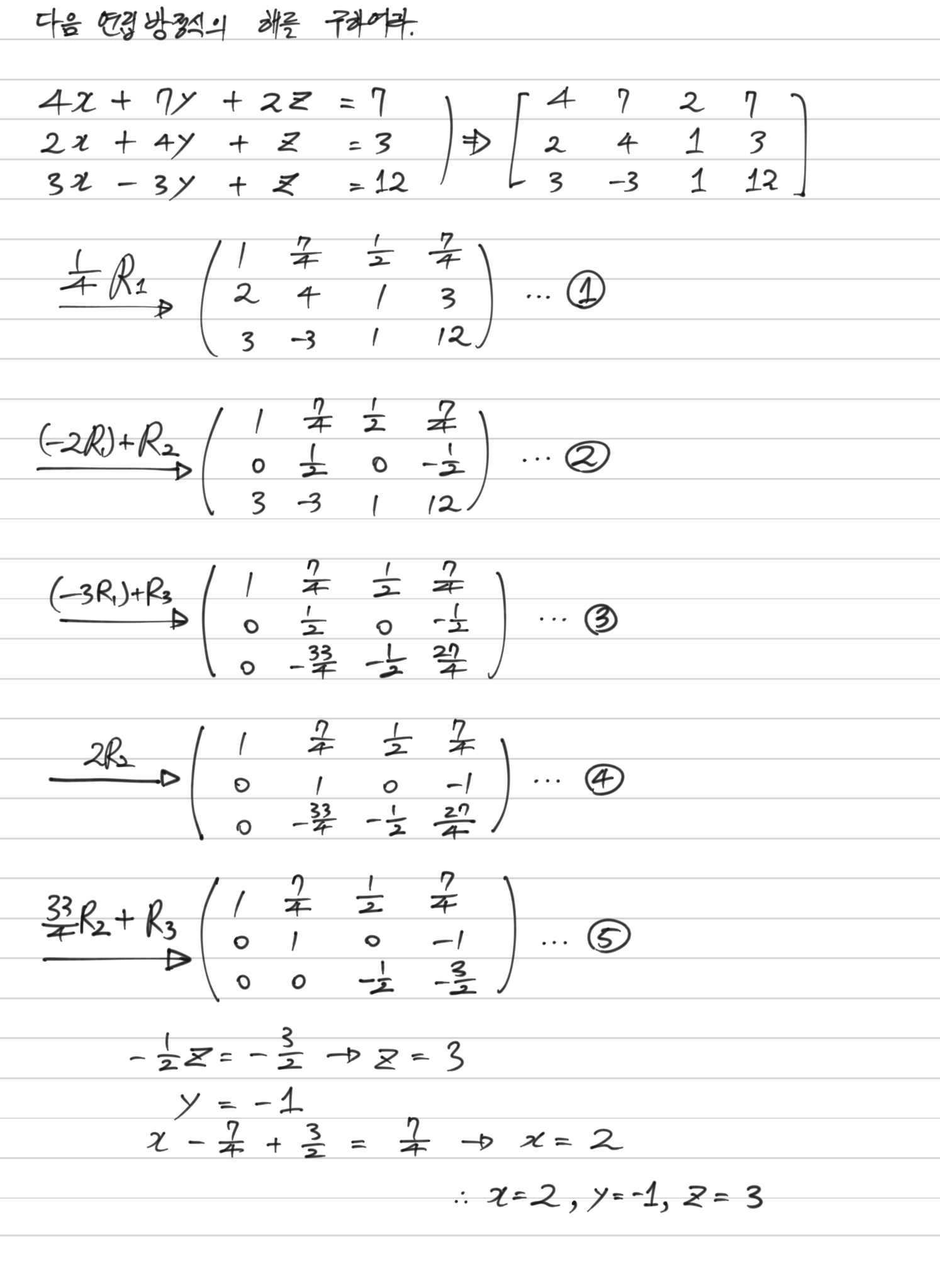

- 내용이 조금 길기 때문에 손으로 풀어보겠다.

- 가우스 소거법은 위에서부터 천천히 아래로 내려가면서, 주대각성분이 1인 상삼각행렬을 만들어가면 된다.

- $①$, 최초 첨가행렬에서 첫 번째 행 $R_1$의 첫 원소인 $A_{11}=4$는 주대각성분이므로 이를 1로 만들어주기 위해, $R_1$에 $\frac{1}{4}$를 곱해주어, $A_{11}=1$로 만들어주었다.

- $②$, 두 번째 행 $R_2$의 첫 원소인 $A_{21}=2$을 0으로 만들어주기 위해, $R_1$의 인자들에 $-2$를 곱하여 $R_2$에 더해주었다.

- $③$, 세 번째 행 $R_3$의 첫 원소인 $A_{31}=3$을 0으로 만들어주기 위해, $R_1$의 인자들에 $-3$을 곱하여 $R_3$에 더해주었다.

- $④$, 두 번째 행 $R_2$의 두 번째 원소인 $A_{22}=\frac{1}{2}$은 주대각성분이므로, $1$로 만들어주기 위해, $2$를 $R_2$에 곱해주었다.

- $⑤$, 세 번째 행 $R_3$의 두 번째 원소인 $A_{32}=-\frac{33}{4}$를 0으로 만들어주기 위해, $R_2$에 $\frac{33}{4}$를 곱하여, $R_3$에 더해주었다.

- 이를 통해, 연립일차방정식의 해인 $x=2,\ y=-1,\ z=3$을 찾았다.

행렬이 연립일차방정식에서 어떻게 나오게 되었고, 행렬을 이용해서 연립일차방정식의 해를 쉽게 찾을 수 있는 가우스 소거법에 대해 간단하게 학습해보았다.

다음 포스트에서는 가우스 소거법에 대해 좀 더 알아보도록 하자.

'Python으로 하는 기초 수학 > 행렬' 카테고리의 다른 글

| 역행렬(Inverse matrix) (0) | 2021.02.26 |

|---|---|

| 영인자(Zero Divisor) (0) | 2021.02.25 |

| 행렬의 성질 (0) | 2021.02.25 |

| 행렬(Matrix) (0) | 2021.02.25 |